Estamos acostumbrados a la repetición, ya un poco cansadora, sobre la IA como gran amenaza existencial y peligro. El alarmismo es impactante, más seductor, «vende más». Varios especialistas han insistido en estos riesgos. Pero no todos los entendidos comparten el pesimismo desolador. Yann Lecun es un autorizado ejemplo de un fundamentado optimismo. LeCun, informático franco-estadounidense, nacido en 1960, es uno de los llamados «padres de la IA», y activo investigador en el campo del aprendizaje automático. En esta entrevista para la Revista Wired, referente en el comentario de los cambios tecnológicos, defiende los beneficios de la IA.

Por ejemplo, aquí sostiene que «la IA traerá muchos beneficios al mundo. Pero la gente está explotando el miedo sobre la tecnología, y corremos el riesgo de ahuyentar a las personas de ella. Ese es un error que cometimos con otras tecnologías que revolucionaron el mundo.»

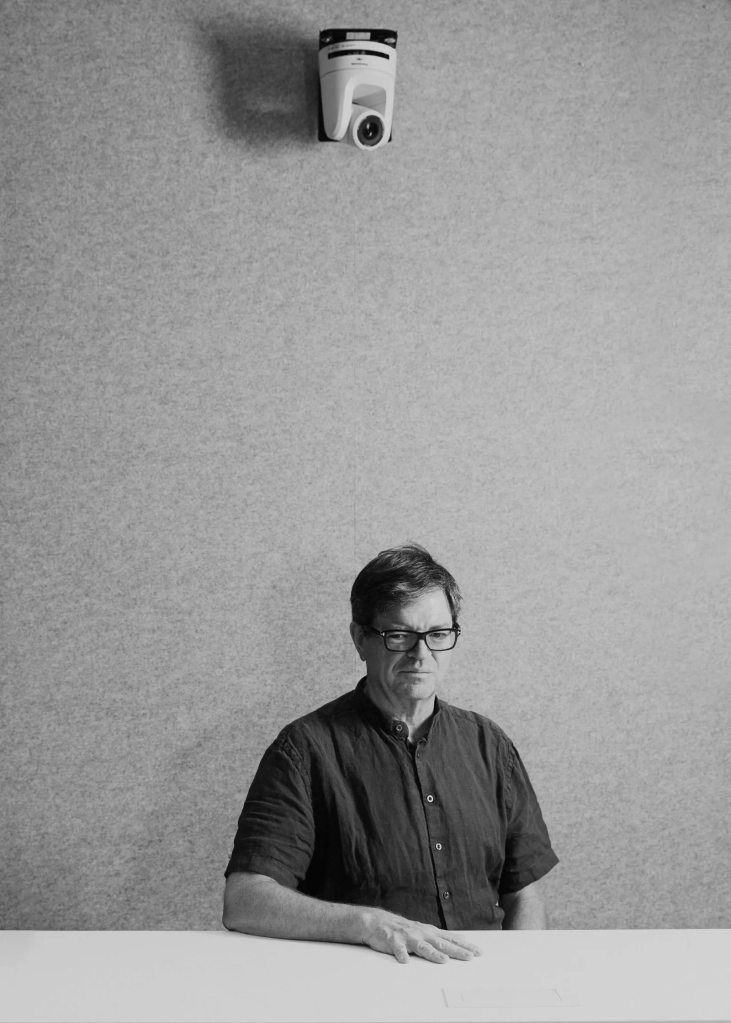

Entrevista de Steven Levy a a Yann LeCun (*)

No hay que sermonear a Yann LeCun. Pionero de la IA moderna y científico en jefe de IA de Meta, LeCun es uno de los defensores más acérrimos de esta tecnología. Se burla de los escenarios distópicos de desinformación sobrecargada e incluso, eventualmente, de la extinción humana. Es conocido por tuitear (o como se llame en el país de X) para denunciar a los miedosos. Cuando sus antiguos colaboradores, Geoffrey Hinton y Yoshua Bengio, encabezaron una declaración que calificaba la IA de «riesgo a escala social», LeCun se mantuvo al margen. En su lugar, firmó una carta abierta al presidente de EE UU, Joe Biden, instando a abrazar la IA de código abierto y declarando que «no debería estar bajo el control de unas pocas entidades corporativas selectas».

Las opiniones de LeCun importan. Junto con Hinton y Bengio, ayudó a crear el enfoque de aprendizaje profundo que ha sido fundamental para elevar el nivel de la inteligencia artificial, un trabajo por el que el trío recibió más tarde el premio Turing, el más alto galardón de la informática. Meta dio un gran golpe cuando la empresa (entonces Facebook) lo contrató como director fundador del laboratorio de investigación de IA de Facebook (FAIR) en 2013. También es profesor en la Universidad de Nueva York (NYU). Más recientemente, ayudó a convencer al CEO, Mark Zuckerberg, para que compartiera con el mundo parte de la tecnología de IA de Meta. Este verano, la empresa lanzó un gran modelo de lenguaje de código abierto llamado Llama 2, que compite con los LLM de OpenAI, Microsoft y Google, las «selectas entidades corporativas» implícitas en la carta a Biden. Los críticos advierten de que esta estrategia de código abierto podría permitir a los malos agentes realizar cambios en el código y eliminar las barreras que minimizan la basura racista y otros resultados tóxicos de los LLM; LeCun, el “Pangloss” más destacado de la IA, cree que la humanidad puede hacerle frente.

Este otoño me senté con LeCun en una sala de conferencias de la oficina de Meta, en Midtown, Nueva York. Hablamos del código abierto, de por qué cree que se exagera el peligro de la IA y de si una computadora podría conmover el corazón humano como lo hace un solo de saxo de Charlie Parker. (LeCun, que creció a las afueras de París, frecuenta los clubes de jazz de Nueva York). Seguimos con otra conversación en diciembre, mientras él asistía a la influyente conferencia anual NeurIPS en Nueva Orleans, en la que se le considera un dios. La entrevista ha sido editada por extensión y claridad.

Steven Levy: En una charla reciente, usted dijo: «El aprendizaje automático es una mierda» ¿Por qué un pionero de la IA como usted diría eso?

Yann LeCun: El aprendizaje automático es genial. Pero la idea de que de algún modo vamos a ampliar las técnicas que tenemos y llegar a una IA de nivel humano… No. No. Nos falta algo grande para conseguir que las máquinas aprendan de forma eficiente, como hacen los humanos y los animales. Aún no sabemos qué es.

No quiero criticar esos sistemas ni decir que sean inútiles, me he pasado mi carrera trabajando en ellos. Pero tenemos que disipar el entusiasmo de algunas personas, que creen que vamos a ampliarlo y que pronto conseguiremos inteligencia humana. En absoluto.

Actúa como si fuera su deber denunciar estas cosas.

Sí. La IA traerá muchos beneficios al mundo. Pero la gente está explotando el miedo sobre la tecnología, y corremos el riesgo de ahuyentar a las personas de ella. Ese es un error que cometimos con otras tecnologías que revolucionaron el mundo. Por ejemplo, la invención de la imprenta en el siglo XV. La Iglesia Católica la odiaba, ¿verdad? La gente iba a poder leer la Biblia por sí misma y no hablar con el cura. Casi toda la clase dirigente estaba en contra del uso generalizado de la imprenta porque cambiaría la estructura de poder. Tenían razón: creó 200 años de conflictos religiosos. Pero también trajo consigo la Ilustración. [Nota: los historiadores podrían señalar que la Iglesia en realidad hizo uso de la imprenta para sus propios fines, pero da igual].

¿Por qué tantas personalidades del mundo de la tecnología hacen sonar la alarma sobre la IA?

Algunas personas buscan llamar la atención, otras son ingenuas sobre lo que realmente está pasando hoy en día. No se dan cuenta de que la IA mitiga peligros como la incitación al odio, la desinformación o los intentos propagandísticos de corromper el sistema electoral. En Meta hemos hecho enormes progresos utilizando la IA para este tipo de cosas. Hace cinco años, de toda la incitación al odio que Facebook retiraba de la plataforma, entre el 20 y el 25% era eliminada preventivamente por sistemas de IA antes de que nadie la viera. El año pasado fue el 95%.

¿Qué opina de los chatbots? ¿Son tan poderosos como para desplazar a los humanos?

Son increíbles. Un gran progreso. Van a democratizar hasta cierto punto la creatividad. Pueden producir textos muy fluidos y con muy buen estilo. Pero son aburridos, y lo que inventan puede ser completamente falso.

«La IA traerá muchos beneficios al mundo. Pero corremos el riesgo de ahuyentar a las personas».

La empresa para la que trabaja parece bastante empeñada en desarrollarlos y ponerlos en productos.

Hay un futuro a largo plazo en el que absolutamente todas nuestras interacciones con el mundo digital (y, en cierta medida, entre nosotros) estarán mediadas por sistemas de IA. Tenemos que experimentar con cosas que ahora mismo no son lo bastante potentes para hacerlo, pero que están en camino de ello. Como los chatbots con los que puedes hablar por WhatsApp. O que te ayuden en tu vida diaria y te ayuden a crear cosas, ya sea texto o traducción en tiempo real, cosas así. O posiblemente en el metaverso.

¿Qué grado de implicación tiene Mark Zuckerberg en el impulso de la IA de Meta?

Mark está muy implicado. Tuve una conversación con Mark a principios de año y le dije lo que acabo de decirte, que hay un futuro en el que todas nuestras interacciones estarán mediadas por la IA. ChatGPT nos mostró que la IA podría ser útil para nuevos productos antes de lo que habíamos previsto. Vimos que el público estaba mucho más cautivado por las capacidades de lo que pensábamos. Así que Mark tomó la decisión de crear una división de productos centrada en la IA generativa.

¿Por qué decidió Meta que el código de Llama se compartiera con otros, al estilo del código abierto?

Cuando tienes una plataforma abierta a la que puede contribuir mucha gente, el progreso es más rápido. Los sistemas que se obtienen son más seguros y funcionan mejor. Imagina un futuro en el que todas nuestras interacciones con el mundo digital estén mediadas por un sistema de IA. No querrás que ese sistema esté controlado por un pequeño número de empresas de la costa oeste de Estados Unidos. Tal vez a los estadounidenses no les importe, tal vez al gobierno estadounidense no le importe. Pero te digo ahora mismo, en Europa, no les va a gustar. Dicen: «Vale, bien, esto habla inglés correctamente. ¿Pero qué pasa con el francés? ¿Y el alemán? ¿Y el húngaro? ¿O el holandés, o lo que sea? ¿Con qué lo has entrenado? ¿Cómo refleja eso nuestra cultura?».

Parece una buena forma de hacer que las startups usen tu producto y de darle un rodillazo a tus competidores.

No necesitamos darle un rodillazo a nadie. Así es como va a ir el mundo. La IA tiene que ser de código abierto porque necesitamos una infraestructura común cuando una plataforma se está convirtiendo en una parte esencial del tejido de la comunicación».

Una empresa que no está de acuerdo con eso es OpenAI, de la que usted no parece ser fan.

Cuando empezaron, imaginaron crear una organización sin fines de lucro para investigar la IA como contrapeso a los malos, como Google y Meta, que dominaban la investigación en el sector. Dije que eso era un error. Y de hecho, se demostró que tenía razón. OpenAI ya no es abierta. Meta siempre ha sido abierta y lo sigue siendo. Lo segundo que dije es que te costará mucho desarrollar una investigación sustancial sobre IA, a menos que tengas una forma de financiarla. Al final, tuvieron que crear una rama con fines de lucro y conseguir inversión de Microsoft. Así que ahora son básicamente un centro de investigación contratado por Microsoft, aunque tienen cierta independencia. Y luego había una tercera cosa, que era su creencia de que la AGI [inteligencia artificial general] está a la vuelta de la esquina, y que ellos iban a ser los que la desarrollaran antes que nadie. Pero no lo harán.

¿Cómo ve el drama de OpenAI, cuando Sam Altman fue destituido como CEO y luego volvió a depender de un consejo diferente? ¿Cree que repercutió en la comunidad investigadora o en la industria?

Creo que el mundo de la investigación ya no se preocupa demasiado por OpenAI, porque no publican ni revelan lo que hacen. Algunos antiguos colegas y estudiantes míos trabajan en OpenAI; nos sentimos mal por ellos debido a las inestabilidades que se produjeron allí. La investigación se nutre realmente de la estabilidad, y cuando se producen sucesos dramáticos como éste, la gente duda. Además, otro aspecto importante para los investigadores es la apertura, y OpenAI ya no es abierta. Así que OpenAI ha cambiado en el sentido de que no se les ve mucho como colaboradores de la comunidad investigadora. Eso está en manos de las plataformas abiertas.

El cambio en OpenAI ha sido calificado como una especie de victoria del «aceleracionismo» de la IA, que es lo contrario del doomerismo. Sé que usted no es un doomer [un apocalíptico], pero ¿es un aceleracionista?

No, no me gustan esas etiquetas. No pertenezco a ninguna de esas escuelas de pensamiento ni, en algunos casos, a sectas. Tengo mucho cuidado de no llevar al extremo este tipo de ideas, porque es demasiado fácil entrar en ciclos puristas que te llevan a hacer cosas estúpidas.

La UE acaba de publicar una serie de normativas sobre IA, y una de las cosas que ha hecho es eximir en gran medida a los modelos de código abierto. ¿Cuál será el impacto de esto en Meta y otros?

Afecta a Meta en cierta medida, pero tenemos suficiente músculo para cumplir cualquier normativa. Es mucho más importante para los países que no tienen recursos propios para construir sistemas de IA desde cero. Pueden confiar en las plataformas de código abierto para tener sistemas de IA que se adapten a su cultura, su idioma y sus intereses. Habrá un futuro, probablemente no muy lejano, en el que la gran mayoría, si no todas, de nuestras interacciones con el mundo digital estarán mediadas por sistemas de IA. No queremos que esas cosas estén bajo el control de un pequeño número de empresas de California.

¿Participó usted en la tarea de ayudar a los reguladores a llegar a esa conclusión?

Sí, pero no directamente con los reguladores. Estuve hablando con varios gobiernos, sobre todo con el francés, pero también indirectamente con otros. Y básicamente, captaron el mensaje de que no se quiere que la dieta digital de los ciudadanos esté controlada por un pequeño número de personas. El gobierno francés entendió ese mensaje muy pronto. Por desgracia, no hablé con personas de la UE que estaban más influidas por las profecías catastrofistas y querían regularlo todo para evitar lo que consideraban posibles catástrofes. Pero eso fue bloqueado por los gobiernos francés, alemán e italiano, que dijeron que había que hacer una provisión especial para las plataformas de código abierto.

¿Pero no es muy difícil controlar y regular una IA de código abierto?

No. Para los productos en los que la seguridad es realmente importante, ya existen normas. Por ejemplo, si se va a utilizar la IA para diseñar un nuevo medicamento, ya existe una normativa para garantizar que el producto sea seguro. Creo que eso tiene sentido. La cuestión que se debate es si tiene sentido regular la investigación y el desarrollo de la IA. Y yo creo que no.

«No quieres que la dieta digital de tus ciudadanos esté controlada por un pequeño número de personas».

¿No podría alguien tomar un sofisticado sistema de código abierto que lance una gran empresa, y usarlo para apoderarse del mundo? Con acceso a los códigos fuente y a los pesos, los terroristas o los estafadores pueden dotar a los sistemas de IA de unidades destructivas.

Necesitarían acceso a 2,000 GPU en algún lugar que nadie pueda detectar, dinero suficiente para financiarlo y talento para hacer el trabajo.

Algunos países tienen mucho acceso a ese tipo de recursos.

En realidad, ni siquiera China lo tiene, porque hay un embargo.

Creo que con el tiempo podrían descubrir cómo fabricar sus propios chips de IA.

Es cierto. Pero sería algunos años detrás del estado de la técnica. Es la historia del mundo: siempre que la tecnología progresa, no se puede evitar que los malos tengan acceso a ella. Entonces es mi IA buena contra tu IA mala. La forma de estar por delante es progresar más rápido. La forma de progresar más rápido es abrir la investigación, para que la comunidad en general contribuya a ella.

¿Cómo define la inteligencia artificial?

No me gusta el término AGI porque no existe la inteligencia general. La inteligencia no es algo lineal que se pueda medir. Diferentes tipos de entidades inteligentes tienen diferentes conjuntos de habilidades.

Cuando las computadoras alcancen el nivel de inteligencia humana, no se detendrán ahí. Con conocimientos profundos, capacidades matemáticas a nivel de máquina y mejores algoritmos, crearán una superinteligencia, ¿verdad?

Sí, no hay duda de que las máquinas acabarán siendo más inteligentes que los humanos. No sabemos cuánto tardarán, pueden ser años o siglos.

En ese momento, ¿tenemos que cerrar las escotillas?

No, no. Todos tendremos asistentes de inteligencia artificial y será como trabajar con un equipo de personas muy inteligentes. Solo que no serán personas. Los humanos se sienten amenazados por esto, pero creo que deberíamos sentirnos entusiasmados. Lo que más me entusiasma es trabajar con gente más inteligente que yo, porque amplifica tus propias capacidades.

Pero si las computadoras se vuelven superinteligentes, ¿por qué nos necesitarían?

No hay razón para creer que porque los sistemas de IA sean inteligentes vayan a querer dominarnos. La gente se equivoca cuando imagina que los sistemas de IA tendrán las mismas motivaciones que los humanos. Simplemente no las tendrán. Los diseñaremos para que no lo hagan.

¿Y si los humanos no incorporamos esas motivaciones y los sistemas de superinteligencia acaban perjudicando a los humanos al perseguir un objetivo con una sola mente? Como el ejemplo del filósofo Nick Bostrom de un sistema diseñado para fabricar clips sin importar nada más, y que se apodera del mundo para fabricar más.

Sería extremadamente estúpido construir un sistema y no construir ninguna barrera. Sería como construir un auto con un motor de 1,000 caballos sin frenos. La única forma de hacer que los sistemas de IA sean controlables y seguros es dotarlos de motores. Yo lo llamo IA dirigida por objetivos. Se trata de una arquitectura nueva, de la que no tenemos ninguna demostración por el momento.

«No hay razón para creer que porque los sistemas de IA sean inteligentes querrán dominarnos».

¿En eso está trabajando ahora?

Sí. La idea es que la máquina tiene objetivos que debe satisfacer, y no puede producir nada que no satisfaga esos objetivos. Esos objetivos pueden incluir barreras para evitar cosas peligrosas o lo que sea. Así es como se hace seguro un sistema de IA.

¿Cree que vivirá para lamentar las consecuencias de la IA que ha ayudado a crear?

Si pensara eso, dejaría de hacer lo que hago.

Usted es un gran aficionado al jazz. ¿Podría algo generado por la IA igualar la creatividad elitista y eufórica que hasta ahora solo pueden producir los humanos? ¿Puede producir obras con alma?

La respuesta es complicada. Sí, en el sentido de que los sistemas de IA acabarán produciendo música, o artes visuales, o lo que sea, con una calidad técnica similar a la de los humanos, quizá superior. Pero un sistema de IA no tiene la esencia de la música improvisada, que depende de la comunicación de estados de ánimo y emociones por parte de un ser humano. Al menos, todavía no. Por eso la música de jazz debe escucharse en vivo.

No me ha contestado si esa música tendría alma.

Ya hay música que no tiene alma. La ponen en los restaurantes como música de fondo. Son productos, producidos en su mayoría por máquinas. Y hay un mercado para eso.

Pero estoy hablando del pináculo del arte. Si le pusiera una grabación que superara a Charlie Parker en su mejor momento, y luego le dijera que la generó una IA, ¿se sentiría engañado?

Sí y no. Sí, porque la música no es solo una experiencia auditiva; gran parte de ella es cultural. Es admiración por el intérprete. Tu ejemplo sería como Milli Vanilli. La veracidad es una parte esencial de la experiencia artística.

Si los sistemas de IA fueran tan buenos como para igualar los logros artísticos de élite y no se conociera la historia de fondo, el mercado se inundaría de música del nivel de Charlie Parker y no podríamos distinguir la diferencia.

No veo ningún problema en ello. Me quedaría con el original por la misma razón por la que seguiría comprando un recipiente de 300 dólares hecho a mano que proviene de una cultura de cientos de años, aunque pueda comprar algo que se vea prácticamente igual por 5 dólares. Todavía voy a escuchar a mis músicos de jazz favoritos en vivo, aunque se puedan emular. Un sistema de IA no es la misma experiencia.

Recientemente recibió un honor del Presidente Macron que no puedo pronunciar…

Chevalier de la Légion d’honneur [Caballero de la Legión de Honor]. Fue creado por Napoleón. Es algo así como el título de caballero en el Reino Unido, excepto que tuvimos una revolución. Así que no llamamos a la gente «Sir».

¿Viene con armamento?

No, no tiene espadas y cosas así. Pero la gente que lo tiene puede llevar una pequeña franja roja en la solapa.

¿Podría un modelo de IA ganar alguna vez ese premio?

A corto plazo, no. De todos modos, no creo que fuera una buena idea.

Fuente: Entrevista de Steven Levy a a Yann LeCun, publicada en Revista Wired el 22 de diciembre de 2023.